| |

| Med Sci (Paris). 2009 January; 25(1): 105–110. Published online 2009 January 15. doi: 10.1051/medsci/2009251105.La place des méthodes in silico, in vitro, in omic dans l’évaluation de la sécurité des médicaments Nancy Claude,1* Françoise Goldfain-Blanc,1 and André Guillouzo2 1Institut de Recherches Internationales Servier, 6, place des Pléiades, 92415 Courbevoie, France 2Inserm U620 et Université de Rennes 1, 35043 Rennes, France |

L’objectif de l’évaluation de la sécurité non clinique des médicaments, autrement appelée toxicologie, est de prévoir les effets indésirables ou toxiques afin de sécuriser leur emploi chez le patient, tant lors des essais cliniques que de la mise sur le marché. Réglementairement, cette évaluation est codifiée par les lignes directrices ICH (International Conference on Harmonisation), et s’effectue essentiellement sur l’animal de laboratoire. Néanmoins, les progrès scientifiques, techniques et bio-informatiques ont mis à la disposition des toxicologues de nouveaux outils prédictifs qui, sans remplacer l’animal de laboratoire dans l’état actuel de nos connaissances, permettent d’éliminer très en amont des molécules à toxicité rédhibitoire, et ainsi diminuer le nombre d’animaux utilisés. Ces techniques, in silico, in vitro et in omic, contribuent au respect du principe des 3 R (Reduce, Refine, Replace) énoncé par Russel et Burch en 1959 [

1] et intégré dans l’encadrement législatif actuel relatif à l’expérimentation animale. Elles permettent en outre de comprendre certains mécanismes de toxicité et de mieux évaluer la pertinence pour le patient des effets observés chez l’animal. |

Ces méthodes, également appelées les SAR ou (Q)SAR pour (Quantitative) Structure-Activity Relationships ou « systèmes experts », font appel à des outils informatiques, d’où leur nom « in silico ». Les SAR représentent une relation entre la structure d’un composé ou d’une classe de composés et un effet biologique, et donnent une réponse de type oui/non. Les (Q)SAR utilisent des modèles mathématiques plus élaborés et donnent des réponses plus complètes. Ces deux catégories reposent sur des bases de données obtenues d’après des études in vivo ou in vitro, ou d’après des observations d’études cliniques, et les relient par des corrélations statistiques aux informations structurales. La qualité des (Q)SAR dépend donc de la qualité de la base de données utilisée. Actuellement, ces méthodes in silico jouent un rôle d’orientation pour l’évaluation de produits pour lesquels aucune donnée n’est disponible. Un exemple est la recherche du potentiel génotoxique d’une molécule. Cette recherche s’effectue très tôt dans le processus de développement, dès l’étape de screening, afin d’éviter la sélection d’une molécule présentant à terme un risque cancérigène. Parmi les nombreux modèles disponibles, l’industrie pharmaceutique va privilégier ceux qui ont été validés, comme DEREK [

2] ou MCASE [

3], très utilisés pour le médicament mais aussi dans l’industrie chimique, et reconnus par les instances réglementaires. Ces bases sont enrichies en permanence par les utilisateurs, ce qui augmente d’année en année leur prédictivité. L’utilisation est très simple : la structure du produit à étudier est saisie grâce à un logiciel de dessin, et le programme applique les lois de relation structure-activité contenues dans le répertoire, ainsi que toutes les données toxicologiques. Le système prédit la toxicité du produit et fournit les éléments sur lesquels il se fonde pour cette prédiction (commentaires, références bibliographiques, données de toxicité…). Ceci permet à l’utilisateur de savoir dans quelle mesure il est en accord avec les prédictions, d’envisager des modifications de structure afin d’obtenir un produit moins toxique, et de conduire une étude bibliographique plus poussée si nécessaire. Ces modèles in silico ont évidemment des limites : pour la génotoxicité, leur prédictivité n’est pas totale (concordance de 65,6 % à 88 %). La combinaison de 3 systèmes (DEREK, MCASE et Awork) permet d’augmenter la concordance (98,7 %) [

4]. Concernant le potentiel de toxicité chronique, le potentiel cancérigène ou la toxicité sur le processus de la reproduction, la prédictivité est limitée car ces effets indésirables résultent d’une multitude de variables, elles-mêmes influencées par divers mécanismes. Néanmoins, pour l’industrie pharmaceutique qui utilise une quantité impressionnante de produits chimiques, cette approche devient incontournable dans le domaine du screening des futurs médicaments, mais également dans l’évaluation de la toxicité des matières premières et des intermédiaires de synthèse pour assurer la sécurité au poste de travail de ses employés. Un rapport de l’ECB (European Chemicals Bureau) suggère que l’utilisation optimale des méthodes in silico dans le cadre de REACH1 pourrait diminuer les besoins en animal de laboratoire de 1,3 à 1,9 millions [

5]. |

Le terme in vitro s’oppose au terme in vivo, ces méthodes pouvant être complémentaires ou alternatives à l’expérimentation animale. Les méthodes in vitro sont de plus en plus utilisées non seulement lors des étapes de screening, mais aussi au cours du développement du médicament. Leur facilité de mise en œuvre, leur isolement de tout contexte physiologique qui permet d’étudier un mécanisme d’action toxique, et surtout la possibilité d’utiliser des cellules humaines qui permettent de s’affranchir des différences interespèces, en font un outil incontournable. Ce dernier point est particulièrement vrai pour les cellules hépatiques. En effet, si les différences de réponse interespèces sont limitées pour une cardiotoxicité ou une hématotoxicité, elles sont fréquentes pour une hépatotoxicité. Près du tiers des molécules qui se révèlent hépatotoxiques dans les essais cliniques ne provoque aucune lésion hépatique chez l’animal [

6]. Cette faible corrélation dans le cas du foie est principalement due à des différences dans les voies et les cinétiques de biotransformation des médicaments et aux variations individuelles dans la réponse humaine, liée à des facteurs génétiques, physiopathologiques et/ou environnementaux. Les modèles hépatiques humains sont donc a priori les plus pertinents pour l’acquisition de données ADME (Absorption, Distribution, Métabolisme, Excrétion). Ils incluent des systèmes cellulaires (tranches de foie, hépatocytes primaires et lignées de cellules hépatiques) et subcellulaires (fractions S9, microsomes, enzymes recombinantes), chaque modèle ayant ses propres intérêts et limites pour préciser les paramètres cinétiques ou établir le profil métabolique d’une molécule, caractériser les enzymes impliquées dans sa biotransformation, démontrer une inhibition ou une induction enzymatique ou encore prédire d’éventuelles interactions avec d’autres composés [

7,

8]. Ces données sont aujourd’hui requises par les agences réglementaires et des recommandations sont publiées par la FDA (Food and Drug Administration aux États-Unis). Dans l’ensemble on observe une bonne corrélation avec les résultats in vivo. Qu’il s’agisse de prédiction ou de mécanismes d’action, l’hépatotoxicité ne peut logiquement être évaluée qu’à partir de cellules humaines compétentes sur le plan métabolique. Jusqu’ici les études in vitro ont surtout été réalisées à partir d’hépatocytes primaires, exposés à un traitement unique, à des concentrations élevées et avec des calculs d’IC50 à l’aide de tests conventionnels. Ceux-ci, nombreux (morphologiques, biochimiques ou métaboliques) et de sensibilité variable, ont conduit à des résultats discutables et il n’existe toujours pas de méthode de référence pour l’évaluation de la toxicité aiguë. Les hépatocytes primaires ont aussi permis de reproduire certains types de toxicité, comme la formation de métabolites réactifs (paracétamol), la phospholipidose (amiodarone, maléate de perhexiline) ou des altérations de type cholestatique. Ils ne sont cependant pas adaptés pour détecter une stéatose caractérisée par l’accumulation de vésicules lipidiques intracytoplasmiques, une fibrose ou une toxicité de type idiosyncratique (imprévisible) apparaissant après des traitements longs et répétés. Il est vraisemblable que des traitements réitérés (chroniques) des systèmes cellulaires in vitro seront nécessaires pour répondre à ce défi. Si pour le foie une cellule, l’hépatocyte, est la cible majeure, dans d’autres tissus (rénal, pulmonaire, nerveux,…) différents types cellulaires sont des cibles potentielles importantes. On dispose de plusieurs modèles cellulaires primaires et certaines lignées sont représentatives du néphron in vivo. En revanche, les modèles in vitro existants ne permettent pas d’évaluer correctement le potentiel neurotoxique de composés chimiques. Aussi, de nouvelles stratégies de toxicologie prédictive et mécanistique sont actuellement développées, reposant sur des modèles cellulaires et des méthodologies plus adaptés. Beaucoup d’espoirs reposent sur l’obtention de lignées de différents types cellulaires provenant de la différenciation de cellules souches humaines mais des étapes restent à franchir [

9]. Dans l’attente, les cellules HepaRG, une nouvelle lignée d’hépatome humain, semblent représenter aujourd’hui le modèle le plus pertinent pour des études de toxicité hépatique aiguë et chronique [

10–

12]. Elles possèdent à la fois la capacité de biotransformation des hépatocytes humains primaires et le potentiel de croissance indéfinie des lignées d’hépatome. Une étude récente a montré une toxicité concentration-dépendante et cumulative de l’aflatoxine B1 liée à la formation d’époxydes par le CYP3A4 dans ces cellules [

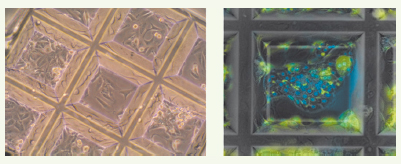

13]. Ces cellules HepaRG permettront donc probablement de reproduire in vitro des lésions hépatiques consécutives à des traitements réitérés, en particulier une stéatose voire une fibrose en les associant avec des cellules étoilées. Pour répondre aux besoins de screening à moyen/haut débit, les cellules primaires, de par leur disponibilité limitée et leur hétérogénéité fonctionnelle, sont peu appropriées au contraire des lignées (telles que les cellules HepaRG) qui représentent des modèles bien maîtrisés, stables et reproductibles. De nouvelles approches reposant sur l’utilisation de puces à cellules couplée à l’imagerie sont en cours de validation. Ces puces nécessitent peu de cellules (quelques centaines par point) et permettent de visualiser 3 ou 4 marqueurs par cellule (Figure 1). Un tel équipement est actuellement utilisé pour le screening de nouvelles molécules anticancéreuses dérivées de produits de la mer.  | Figure 1.

Puce à cellules utilisant des cellules HepaRG. A. Cellules indifférenciées proliférantes. B. Cellules différenciées avec marquage des noyaux (bleu) et des canalicules biliaires (vert) (Christiane Guguen-Guillouzo, Plate-forme Imagerie-Puce à cellules, Génopôle Ouest, Rennes, France). |

|

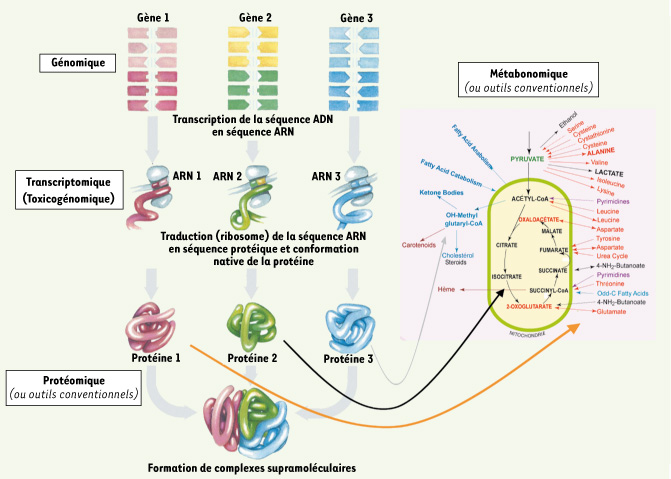

Parmi les disciplines émergentes en toxicologie, les technologies reconnaissables par le suffixe « omic » ont pris une place prépondérante au cours de ces dernières années et sont toujours en constante évolution. L’apparition des « omics » a permis d’envisager une meilleure prédiction de la toxicité des nouvelles molécules, soit plus précocement lorsqu’elles sont utilisées comme outils prédictifs, soit plus précisément en tant qu’outils mécanistiques. Ces technologies sont fondées sur le fait qu’un événement physiologique, pharmacologique ou toxicologique va modifier la composition protéique et l’activité des cellules, donc leur fonction. Les modifications peuvent être détectées à différents niveaux cellulaires (Figure 2). En toxicologie, il s’agit souvent d’évaluer les profils (ou signatures) de modifications obtenus après exposition à un produit et de les comparer à des profils témoins ou caractéristiques de toxicités connues.  | Figure 2.

Les différentes technologies « Omics » en toxicologie. La terminologie « omic » s’utilise pour des analyses à différents niveaux cellulaires. 1. Génomique ou pharmacogénomique, pour les modifications géniques, très utilisée pour l’analyse de différents variants et le typage de certaines populations dans les essais thérapeutiques ou les patients mais peu utilisée en toxicologie. 2. Transcriptomique ou Toxicogénomique, très utilisée en toxicologie, et concernant les surexpressions ou les répressions des ARNm après traitement par une molécule candidate. 3. Protéomique, qui peut valider les hypothèses émises d’après la toxicogénomique, et mettre en valeur des phénomènes de régulation post-transcriptionnels. 4. Métabonomique, qui mesure le résultat à l’échelle de la cellule ou de l’organisme des modifications primaires subcellulaires (phénotype métabolique). |

La toxicogénomique Elle s’intéresse aux modifications de l’expression des gènes en réponse à un médicament, un toxique ou une pathologie [

14] ; le terme « transcriptomique » serait plus juste, puisque ce sont les ARNm qui sont mesurés, souvent par des puces à ADN ou par RT-PCR. C’est la technologie « omic » prépondérante en toxicologie, associée aux outils traditionnels, tels que l’histologie ou la biologie clinique. La protéomique Elle est souvent utilisée en complément des analyses transcriptomiques, par la mesure quantitative et qualitative des protéines dans un tissu. En effet, les nombreux phénomènes post-transcriptionnels peuvent faire que les modifications des ARNm ne soient pas traduites en modifications fonctionnelles ou quantitatives des protéines. Les techniques le plus souvent utilisées sont l’électrophorèse en deux dimensions ou la spectrométrie de masse. La métabonomique ou métabolomique Ce sont deux termes maintenant considérés comme équivalents, leur distinction étant plus historique que scientifique [

15]. La métabonomique est « la mesure quantitative au cours du temps de la réponse métabolique d’un biosystème à un stimulus pathophysiologique ou une modification génétique » [

16]. Il s’agit de mesurer la réponse finale de l’organisme via l’analyse globale des molécules de faible poids moléculaire (acides aminés, acides organiques, sucres, lipides…) dans un échantillon biologique ou un tissu. L’intérêt est la détection de biomarqueurs de toxicité facilement accessibles, et donc leur possible extrapolation à l’homme. En raison de la variété chimique des molécules détectées, différentes techniques sont associées telles que RMN (résonance magnétique nucléaire) ou spectrométrie de masse (LC-MS, GC-MS, etc.). Un intérêt majeur des « omics » est de prédire les effets à long terme d’un produit via leur utilisation dans des essais à court terme. Il est admis que des toxiques agissant par le même mécanisme d’action entraînent des profils de dérégulation génique ou métabonomique similaires et caractéristiques. En regroupant les profils de toxiques bien connus et en reliant ces dérégulations à leur expression phénotypique, une « signature » caractéristique de la toxicité considérée peut être établie et l’on peut donc prédire très tôt les éventuels effets d’une molécule candidate. Ce type d’analyse nécessite des bases de données suffisamment importantes pour être prédictives. De nombreuses publications ont déjà établi, par exemple, des listes de gènes ou de métabolites potentiellement prédictifs d’hépatotoxicité selon divers mécanismes [

17], de néphrotoxicité [

18] ou de carcinogénicité [

19]. Dans ce cas, des signatures transcriptomiques discriminant un mode d’action génotoxique ou non génotoxique ont été obtenues après traitement de rats durant 14 jours avec des carcinogènes connus et prédisent à 88 % les résultats d’études de cancérogenèse obtenus après 2 ans de traitement. Le même type d’approche existe en protéomique [

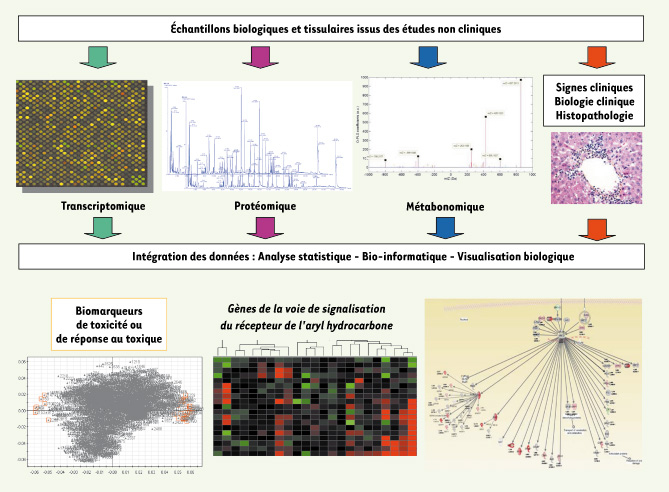

20]. Les « omics » sont également largement utilisés dans la compréhension des mécanismes de toxicité, indispensable pour évaluer la pertinence interespèce des effets observés ou établir des seuils de sécurité (Figure 3). La recherche du mécanisme peut conduire à l’identification de marqueurs précoces de toxicité, permettant d’utiliser l’information pour sélectionner d’autres candidats. Par exemple, le mécanisme de la phospholipidose a été caractérisé au niveau transcriptionnel dans le modèle de lignée humaine HepG2 [

21]. L’analyse a révélé une douzaine de gènes directement liés au mécanisme de stockage des phospholipides dans la cellule et pouvant être utilisés comme marqueurs prédictifs de la toxicité.  | Figure 3.

Intégration d’une plate-forme Omics. Cette figure schématise les différents niveaux d’analyse et d’intégration des données « omics » entre elles et avec les données issues d’outils plus conventionnels. L’analyse de plusieurs milliers de données ne peut se faire que grâce à des plates-formes informatiques et des outils statistiques permettant de trier et sélectionner les variables d’intérêt, pour ensuite analyser les modifications observées sur le plan biologique et toxicologique. Là encore, des outils bio-informatiques sont indispensables pour replacer les modifications dans des voies de signalisation connues ou des listes de transcrits ou métabolites déjà reconnues comme signatures de phénomènes toxiques. |

Sur le plan réglementaire, la FDA comme l’EMEA (European Medicines Agency) se montrent très attentives à l’essor de ces nouvelles techniques et ont chacune créé un groupe multidisciplinaire de réflexion et d’évaluation de ces données. Leurs missions sont de préparer la réglementation à ces évolutions, d’élaborer ou d’adapter les lignes directrices pour la soumission de telles données, d’évaluer les dossiers concernés ou de participer à différents groupes ou consortiums conjointement aux industriels et aux académiques. Les soumissions des données « omics » sont encouragées par des textes tels que les « Voluntary Genomic Data Submisssion » (VGDS), étendues aux « Voluntary Omics Data Submissions » (VXDS), applicables aux niveaux Européen ou Américain. Ces initiatives viennent d’aboutir à la validation de 7 nouveaux marqueurs de néphrotoxicité [

22] plus prédictifs et précoces que les traditionnels urée/créatinine pour la détection d’une atteinte rénale aiguë. Par ailleurs, les agences participent à la mise en place des standards techniques par des initiatives comme le projet MAQC (MicroArray Quality Control), visant à évaluer les performances des différentes technologies, méthodes d’analyse et la reproductibilité des résultats selon les plates-formes ou les laboratoires [

23]. |

Les modèles expérimentaux en toxicologie ont évolué avec le développement de nouvelles techniques en biologie cellulaire, moléculaire et de bio-informatique. Il n’existe pas de modèle unique pour répondre à toutes les questions biomédicales, mais le déploiement des méthodes in silico, in vitro et in omic ainsi que leur validation et leur reconnaissance au niveau réglementaire permet à la fois d’améliorer la détection précoce des effets indésirables et d’avoir recours à l’animal de laboratoire plus en aval dans le développement de nouveaux médicaments. Ceci représente un progrès considérable en termes de pertinence des données obtenues tout en diminuant le nombre d’animaux de laboratoire utilisés. |

Footnotes |

1. Russel WMS, Burch RL. The principles of human experimental technique (1959). Universities Federation for Animal Welfare (UFAW). Herts, UK : Potters Bar, 1992 (special edition) : 238 p. 2. Greene N, Judson PN, Langowski JJ, Marchant CA. Knowledge-based expert systems for toxicity and metabolism prediction: DEREK, StAR and METEOR. SAR QSAR Environ Res 1999; 10 : 299–314. 3. Rosenkranz HS, Cunningham AR, Zhang YP, et al. Development, characterization and application of predictive-toxicology models. SAR QSAR Environ Res 1999; 10 : 277–98. 4. Hayashi M, Kamata E, Hirose A, et al.

In silico assessment of chemical mutagenesis in comparison with results of Salmonella microsome assay on 909 chemicals. Mutat Res 2005; 588 : 129–35. 5. Lewis A, Kazantis N, Fishtik I, et al. Integrating process safety with molecular modelling-based risk assessment of chemicals within REACH regulatory framework: benefit and future challenges. J Hasard Mat 2007; 142 : 592–602. 6. Olson H, Betton G, Robinson D, et al. Concordance of the toxicity of pharmaceuticals in humans and in animals. Regul Toxicol Pharmacol 2000; 32 : 56–67. 7. Guillouzo A. Liver cell models in in vitro toxicology. Environ Health Perspect 1998; 106 (suppl 2) : 511–32. 8. Hewitt NJ, Lechón MJ, Houston JB, et al. Primary hepatocytes: current understanding of the regulation of metabolic enzymes and transporter proteins, and pharmaceutical practice for the use of hepatocytes in metabolism, enzyme induction, transporter, clearance, and hepatotoxicity studies.Drug Metab Rev 2007; 39 : 159–234. 9. Mannello F, Tonti GA. Concise review: no breakthroughs for human mesenchymal and embryonic stem cell culture: conditioned medium, feeder layer, or feeder-free; medium with fetal calf serum, human serum, or enriched plasma; serum-free, serum replacement nonconditioned medium, or ad hoc formula ? All that glitters is not gold! Stem Cells 2007; 25 : 1603–9. 10. Gripon P, Rumin S, Urban S, et al. Infection of a human hepatoma cell line by hepatitis b virus. Proc Natl Acad Sci USA 2002; 99 : 15655–60. 11. Cerec V, Glaise D, Garnier D, et al. Transdifferentiation of hepatocyte-like cells from the human hepatoma heparg cell line through bipotent progenitor. Hepatology 2007; 45 : 957–67. 12. Aninat C, Piton A, Glaise D, et al. Expression of cytochromes p450, conjugating enzymes and nuclear receptors in human hepatoma heparg cells. Drug Metab Dispos 2006; 34 : 75–83. 13. Josse R, Aninat C, Glaise D, et al. Long-term functional stability of human heparg hepatocytes and use for chronic toxicity and genotoxicity studies. Drug Metab Dispos 2008; 36 : 1111–8. 14. Suter L, Babiss LE, Wheeldon EB. Toxicogenomics in predictive toxicology in drug development. Chem Biol 2004; 11; 161–71. 15. Robertson DG. Metabonomics in toxicology: a review. Toxicol Sci 2005; 85 : 809–22. 16. Nicholson JK, Lindon JC, Holmes E. Metabonomics: understanding the metabolic responses of living systems to pathophysiological stimuli via multovariate statistical analysis of biological NMR spectroscopic data. Xenobiotica 1999; 29 : 1181–9. 17. McMillian M, Nie A, Parker B, et al. Drug-induced oxidative stress in rat liver from a toxicogenomic perspective. Toxicol Appl Pharmacol 2005; 207 : 171–8. 18. Wang EJ, Snyder RD, Fielden MR, et al. Validation of putative biomarkers of nephrotoxicity in rats. Toxicology 2008; 246 : 91–100. 19. Ellinger-Ziegelbauer H, Gmuender H, Badenburg A, Ahr HJ. Prediction of a carcinogenic potential of rat hepatocarcinogens using toxicogenomics analysis of short-term in vivo studies. Mutat Res 2008; 637 : 23–39. 20. Fella K, Gluckmann M, Hellmann J, et al. Use of two-dimensional gel electrophoresis in predictive toxicology: Identification of potential early protein bimarkers in chemically induced hepatocarcinogenesis. Proteomics 2005; 5 : 1914–27. 21. Sawada H, Takami K, Asahi S. A toxicogenomic approach to drug-induced phospholipidosis: analysis of its induction mechanism and establishment of a novel in vitro screening system. Toxicol Sci 2005; 83 : 282–92. 22. European Medicines Agency (EMEA). Final report on the pilot joint EMEA/FDA VXDS experience on qualification of nephrotoxicity biomarkers. EMEA, 2008 (Ref EMEA/250885/2008). 23. MAQC Consortium. The microarray quality control (MAQC) project shows inter and intraplatform reproducibility of gene expression measurements. Nat Biotechnol 2006; 24 : 1151–61. |